你有過這種經驗嗎?剛開始跟 ChatGPT 或 Gemini 聊天時,它顯得聰明絕頂,但隨著對話變長,它開始忘東忘西、答非所問,甚至像喝醉了一樣產生幻覺。這並非因為你問錯了問題,而是 AI 正在經歷一場隱形的認知危機——「情境腐敗(Context Rot)」。

在我們追求更長、更大的「上下文窗口」時,事實證明,餵給 AI 越多資訊,並不代表它會變得越聰明。以下是 DotAI 小編整理出的 5 個最具衝擊力的 AI 協作洞察。

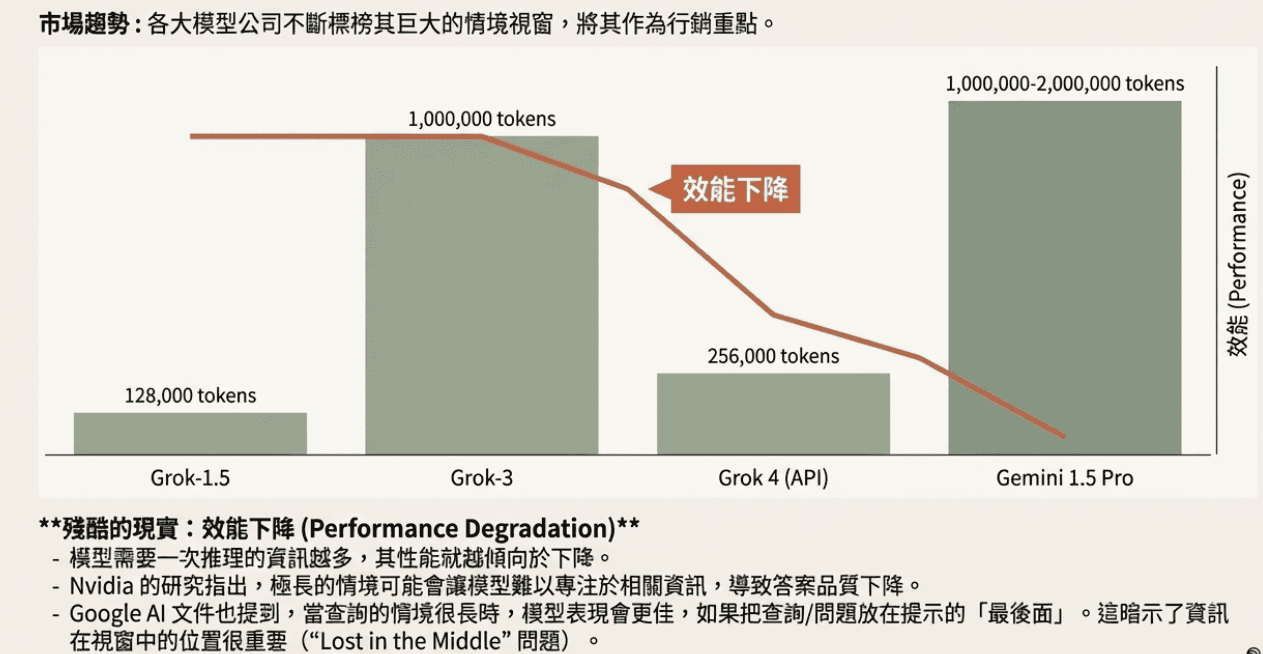

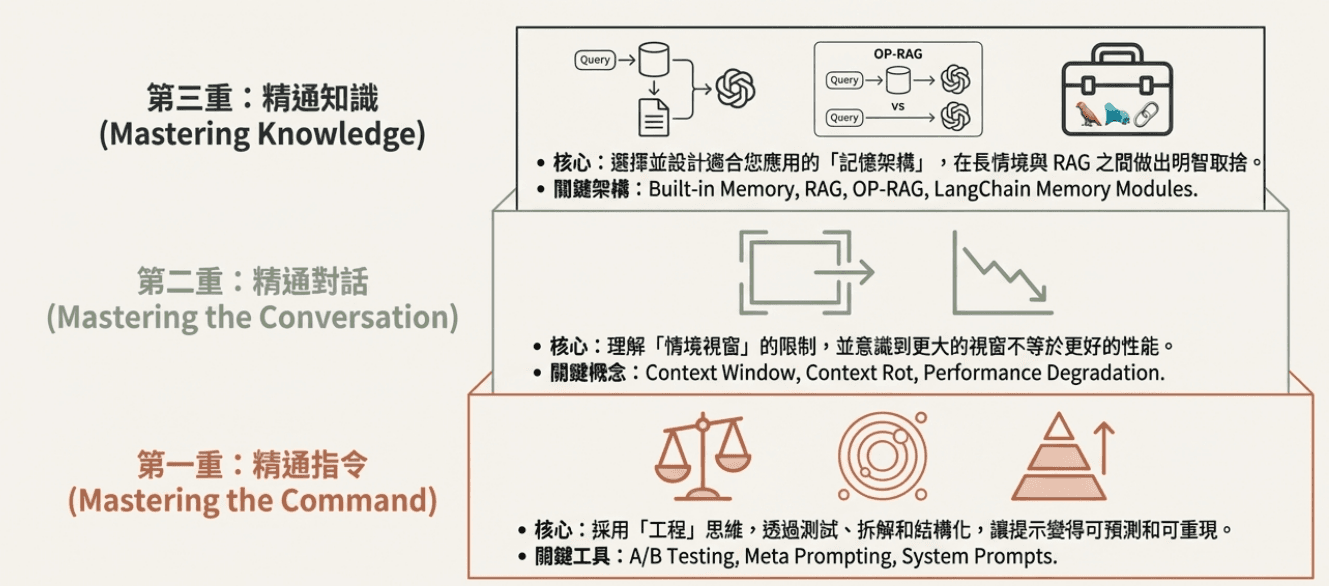

1. 情境腐敗:為什麼 AI 讀越多,表現越差?

一個違反直覺的事實是:即使廠商宣稱擁有百萬級的 Token 窗口,AI 的推理效能仍會隨著資訊量增加而下降。所有輸入的對話紀錄、文件和指令都在「爭奪」模型的注意力。

當負擔過重時,AI 的邏輯會開始崩潰,這種現象被稱為 情境腐敗(Context Rot)。這告訴我們:**「少即是多」**在 AI 時代依然適用,精簡輸入內容才是維護 AI 智商的關鍵。

「模型需要同時推理的資訊越多,效能往往就越下降。」

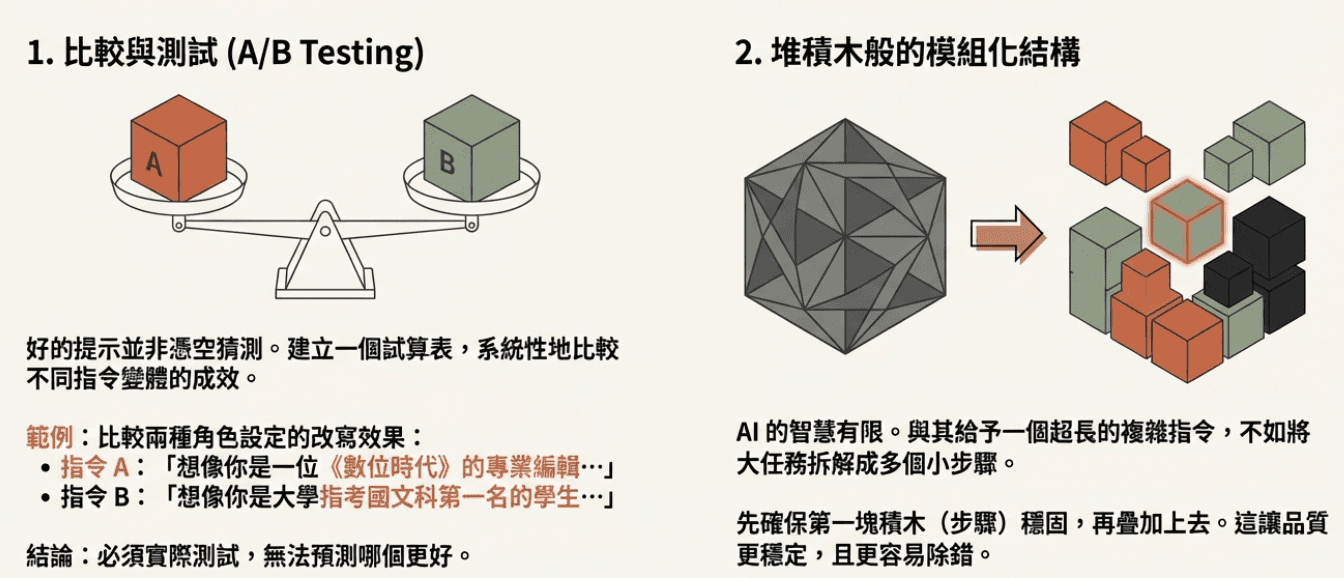

2. 提示工程:它是嚴謹的 SOP,而非魔法咒語

許多人將提示詞(Prompt)稱為「咒語」,但專業人士將其視為一種結構化且可重現的工程學。

最驚人的發現是,你無法憑空猜測哪種指令效果最好。DotAI 小編建議,應將大任務拆解成如「堆積木」般的小步驟(Decomposition),這不僅能讓品質更穩定,也更容易除錯。透過 AB 測試(比較不同的人設設定),我們才能找出最能精準「奴役」AI 的指令。

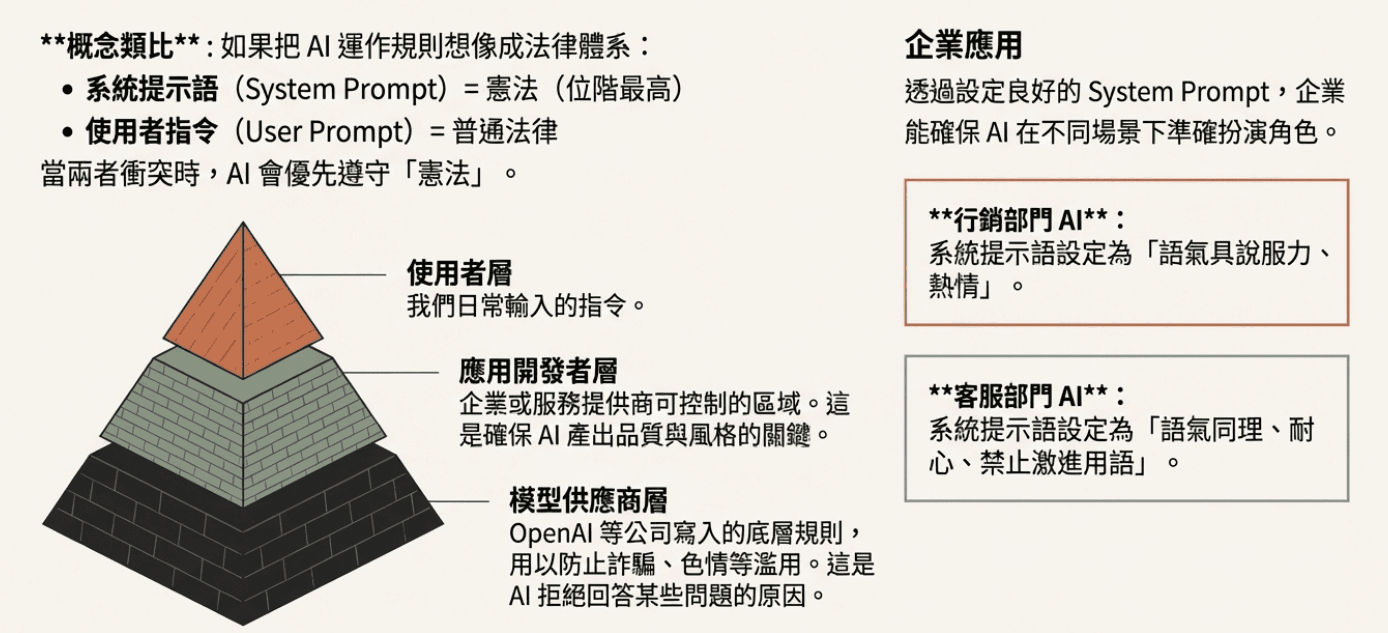

3. 系統提示語:AI 心中不可撼動的「憲法」

如果你覺得 AI 有時很固執,那是因為它必須遵守它的「憲法」。據業內共識,AI 的指令層級大致可以分為三層,而 系統提示語(System Prompt) 對一般用戶來說是位於最高位階。

無論使用者在對話中如何誘導,一旦指令與系統提示語衝突,AI 會優先遵守最高層級的規範。對於企業來說,這層「憲法」是防止 AI 被使用者「越獄(Jailbreak)」並確保回應風格一致的關鍵安全邊界。

4. OP-RAG 的逆襲:16k 竟能贏過 128k

當 Gemini 推出 200 萬 Token 窗口時,很多人認為「檢索增強生成(RAG)」已死,但研究顯示事實正好相反。

NVIDIA 提出的 OP-RAG(順序保留檢索) 發現:與其讓模型看 12.8 萬個 Token,不如篩選出 1.6 萬個關鍵 Token 並保持其原始文件順序。這種方式產出的答案準確度(F1 分數)高達 44.43,遠勝過無 RAG 的 12.8 萬全文本(僅 34.32)。這證明了「邏輯完整性」比「海量資訊」更重要。

5. 跨對話記憶:打造你的專屬 AI 秘書

過去,每次開啟新對話都要重新訓練 AI,但 ChatGPT 的「Memory(記憶)」功能改變了這點。

這項功能會自動聚合並修正你提到的個人資訊、專業語氣或語言偏好。例如,一旦它記住你偏好「繁體中文」與「條列式清單」,之後在任何新的對話室,它都會主動套用這些設定。

💡 常見問題 (FAQ)

Q1:我應該把問題放在對話的最前面還是最後面? 在處理長文本時,將查詢或問題放在對話的最後面,AI 的表現通常會更好。

Q2:對話窗口(Context Window)越大,反應會越慢嗎? 是的。雖然任何請求都有固定延遲,但通常查詢內容越長,延遲(首個 Token 產出的時間)會隨之增加。

Q3:如果我有超長的文件(如一本書)要處理,該怎麼辦? 建議採用「遞迴摘要(Recursive Summarization)」:先將文件分段摘要,再將這些摘要串聯起來進行二次摘要,直到完成全文總結。

Q4:什麼是「無痕模式(Temporary Chat)」? 這是一種保護隱私的對話模式,對話內容不會被記錄在歷史中,也不會成為 AI 的訓練資料,且不會觸發記憶功能。

總結:從下指令到管理智慧

未來的 AI 協作將從「單次溝通」轉向「情境管理」。當我們能精準控制 AI 的注意力,並有策略地過濾噪音時,AI 才能發揮出真正的十倍生產力。下一次對話前,你打算讓你的 AI 記住什麼,又該讓它忘掉什麼呢?

參考來源

1.- 數位時代:《3個秘訣教你寫出「神級提示詞」,Gemini、ChatGPT都可用!》

2.- 電腦玩物:Esor Huang《ChatGPT 跨對話記憶、無痕模式教學,訓練 AI 記住特殊要求實測》 3. 影片講座:Context Management is a key component of the effective LLM usage.

4.- Reddit 討論區:Grok 3's Memory

5.- Data Studios:Grok Context Window Capabilities Across Model Generations

6.- Google API 文件:Long context | Gemini API

7.- KI-Insights / OpenAI:Prompt engineering Strategy Guide

8.- SuperAnnotate:RAG vs. Long-context LLMs

9.- ProjectPro:Types of LangChain Memory and How to Use Them

DotAI Spot

AI 實戰成長社群

DotAI 全新學習體驗,陪伴您跨越 AI 學習迷惘

其他文章